Wenn Sie sich mit Cloud-native Technologien und Containern beschäftigen, sind Ihnen wahrscheinlich Docker und Kubernetes begegnet. Aber wie stehen die beiden zueinander? Handelt es sich um Kubernetes vs Docker oder um Kubernetes und Docker – oder vielleicht sogar beides?

Was ist der Unterschied zwischen Kubernetes und Docker?

Docker ist eine Suite von Softwareentwicklungswerkzeugen zum Erstellen, Teilen und Ausführen einzelner Container. Kubernetes hingegen ist ein System zur Verwaltung containerisierter Anwendungen im großen Maßstab.

Stellen Sie sich Container als standardisierte Verpackung für Microservices vor, die den gesamten Anwendungscode und die Abhängigkeiten enthalten. Das Erstellen dieser Container ist das Fachgebiet von Docker. Ein Container kann überall ausgeführt werden, sei es auf einem Laptop, in der Cloud, auf lokalen Servern oder sogar auf Edge-Geräten.

Eine moderne Anwendung besteht aus vielen Containern. Die Verwaltung dieser Container in der Produktion ist die Aufgabe von Kubernetes. Da Container leicht repliziert werden können, können Anwendungen automatisch skaliert werden, um den Benutzeranforderungen gerecht zu werden.

Kubernetes und Docker sind größtenteils komplementäre Technologien, die sich ergänzen. Allerdings bietet Docker auch ein System zur Verwaltung containerisierter Anwendungen im großen Maßstab namens Docker Swarm – Kubernetes vs Docker Swarm. Lassen Sie uns untersuchen, wie sich Kubernetes und Docker ergänzen und miteinander konkurrieren.

Was ist Docker?

Ähnlich wie Menschen “Xerox” als Synonym für Kopien benutzen und statt “Internet-Suche” lieber “Google” sagen, ist Docker mit Containern gleichzusetzen. Aber Docker ist mehr als nur Container.

Docker ist eine Suite von Tools für Entwickler zum Erstellen, Teilen, Ausführen und Orchestrieren containerisierter Apps.

Wie funktioniert Docker?

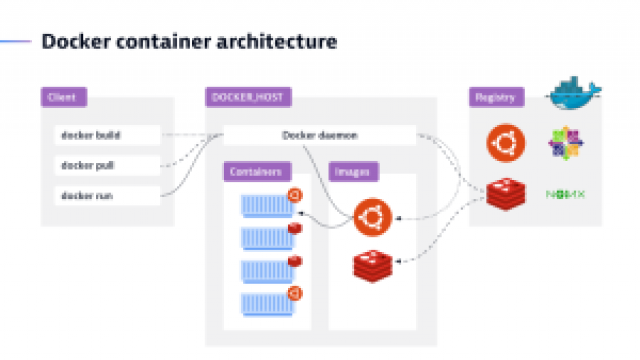

In der Client-Server-Architektur von Docker spricht der Client mit dem Daemon, der für das Erstellen, Ausführen und Verteilen von Docker-Containern verantwortlich ist. Während der Docker-Client und -Daemon auf demselben System ausgeführt werden können, können Benutzer auch einen Docker-Client mit einem Remote-Docker-Daemon verbinden.

Entwicklertools zum Erstellen von Container-Images

Mit Docker Build können Container-Images erstellt werden, die die Blaupause für einen Container darstellen und alles enthalten, was zur Ausführung einer Anwendung erforderlich ist – der Anwendungscode, Binärdateien, Skripte, Abhängigkeiten, Konfiguration, Umgebungsvariablen usw. Docker Compose ist ein Tool zur Definition und Ausführung von Multi-Container-Anwendungen. Diese Tools sind eng mit Code-Repositories (wie GitHub) und Continuous Integration und Continuous Delivery (CI/CD)-Pipeline-Tools (wie Jenkins) integriert.

Teilen von Images

Docker Hub ist ein von Docker bereitgestellter Registry-Service zum Finden und Teilen von Container-Images mit Ihrem Team oder der Öffentlichkeit. Docker Hub bietet ähnliche Funktionen wie GitHub.

Ausführen von Containern

Docker Engine ist eine Container-Runtime, die in nahezu jeder Umgebung verwendet werden kann: Mac- und Windows-PCs, Linux- und Windows-Server, in der Cloud und auf Edge-Geräten. Docker Engine basiert auf containerd, der führenden Open-Source-Container-Runtime, einem Projekt der Cloud Native Computing Foundation (CNCF).

Integrierte Container-Orchestrierung

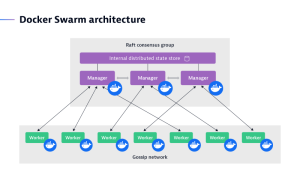

Docker Swarm verwaltet einen Cluster von Docker Engines, die in der Regel auf verschiedenen Knoten ausgeführt werden und als Schwarm bezeichnet werden. Hier beginnt die Überlappung mit Kubernetes.

Was ist Kubernetes?

Kubernetes ist eine Open-Source-Container-Orchestrierungsplattform zur Verwaltung, Automatisierung und Skalierung containerisierter Anwendungen. Kubernetes ist der de facto Standard für die Container-Orchestrierung aufgrund seiner größeren Flexibilität und Skalierbarkeit, obwohl Docker Swarm ebenfalls ein Orchestrierungstool ist.

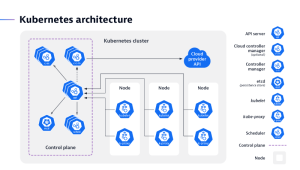

Wie funktioniert Kubernetes?

Ein Kubernetes-Cluster besteht aus Knoten, auf denen containerisierte Anwendungen ausgeführt werden. Jeder Cluster hat mindestens einen Worker-Knoten. Der Worker-Knoten beherbergt die Pods, während die Control Plane die Worker-Knoten und Pods im Cluster verwaltet.

Wofür wird Kubernetes verwendet?

Organisationen verwenden Kubernetes, um die Bereitstellung und Verwaltung containerisierter Anwendungen zu automatisieren. Anstatt jeden Container in einem Cluster einzeln zu verwalten, kann ein DevOps-Team Kubernetes sagen, wie die erforderlichen Ressourcen im Voraus zu verteilen sind.

Bei der Betrachtung von Kubernetes vs Docker geht es in Wirklichkeit um Kubernetes vs Docker Swarm.

Vorteile der Verwendung von Kubernetes und Docker

Kubernetes und Docker-Container bieten gemeinsam mehrere Vorteile für Unternehmen, die containerisierte Anwendungen im großen Maßstab bereitstellen und verwalten möchten.

Einige der wichtigsten Vorteile der Verwendung sind:

-

Skalierbarkeit: Kubernetes kann containerisierte Anwendungen bei Bedarf hoch- oder herunterskalieren und sicherstellen, dass sie immer die benötigten Ressourcen für optimale Leistung haben. Dies ist hilfreich für Anwendungen, die einen Anstieg des Datenverkehrs oder der Nachfrage verzeichnen.

-

Hohe Verfügbarkeit: Kubernetes kann sicherstellen, dass containerisierte Anwendungen hoch verfügbar sind, indem es automatisch Container neu startet, die fehlschlagen oder beendet werden. Dadurch bleibt die Anwendung reibungslos in Betrieb und Ausfallzeiten werden vermieden.

-

Portabilität: Docker-Container sind portierbar, was bedeutet, dass sie einfach von einer Umgebung in eine andere verschoben werden können. Dies ermöglicht es, containerisierte Anwendungen über verschiedene Infrastrukturen hinweg bereitzustellen, z.B. auf lokalen Servern, öffentlichen Cloud-Anbietern oder hybriden Umgebungen.

-

Sicherheit: Kubernetes kann containerisierte Anwendungen durch rollenbasierte Zugriffskontrolle, Netzwerkisolierung und das Scannen von Container-Images absichern. Dadurch wird die Anwendung vor unbefugtem Zugriff, bösartigen Angriffen und Datenverletzungen geschützt.

-

Benutzerfreundlichkeit: Kubernetes kann die Bereitstellung, Skalierung und Verwaltung von containerisierten Anwendungen automatisieren. Dadurch sparen Organisationen Zeit und Ressourcen, und es hilft auch, das Risiko von menschlichen Fehlern zu reduzieren.

-

Kosteneinsparungen: Durch die Automatisierung der Bereitstellung und Verwaltung von containerisierten Anwendungen können Kubernetes und Docker dazu beitragen, die Betriebskosten der IT zu reduzieren.

-

Erhöhte Agilität: Kubernetes und Docker können Organisationen dabei helfen, agiler zu sein, indem sie die Bereitstellung neuer Funktionen und Updates für Anwendungen erleichtern.

-

Erhöhte Innovation: Kubernetes und Docker können Organisationen dabei helfen, Innovationen schneller voranzutreiben, indem sie eine Plattform bieten, die einfach zu bedienen und skalierbar ist.

Anwendungsfälle für Kubernetes und Docker

Wenn Kubernetes und Docker gemeinsam verwendet werden, eröffnen sie eine Vielzahl von Möglichkeiten für eine nahtlose und skalierbare Bereitstellung von Anwendungen.

Hier sind einige Anwendungsfälle für die Verwendung von Kubernetes und Docker zusammen:

-

Bereitstellung und Verwaltung von Microservices-Anwendungen: Microservices-Anwendungen bestehen aus kleinen, unabhängigen Komponenten, die einfach skaliert und bereitgestellt werden können. Jeder Microservice kann mit Docker containerisiert werden, und Kubernetes kann die Bereitstellung und Skalierung dieser Services unabhängig voneinander verwalten. Dies ermöglicht eine bessere Wartbarkeit, Skalierbarkeit und Fehlerisolierung.

-

Dynamisches Skalieren: Gemeinsam ermöglichen Kubernetes und Docker das dynamische Skalieren von Anwendungen. Kubernetes kann die Anzahl der Anwendungsinstanzen automatisch an die Nachfrage anpassen. Bei starkem Verkehr können neue Container gestartet werden, um die Last zu bewältigen, und bei geringerem Verkehr können überflüssige Container skaliert werden. Diese Elastizität gewährleistet eine effiziente Ressourcennutzung und Kosteneinsparungen.

-

Ausführen von containerisierten Anwendungen auf Edge-Geräten: Kubernetes kann verwendet werden, um containerisierte Anwendungen auf Edge-Geräten auszuführen und sicherzustellen, dass sie immer verfügbar und auf dem neuesten Stand sind. Docker hat die Art und Weise, wie Anwendungen verpackt und isoliert werden, neu definiert. Docker eliminiert das Problem “Es funktioniert auf meinem Computer” durch die Verkapselung einer Anwendung und ihrer Abhängigkeiten in einem standardisierten Container. Diese Konsistenz gewährleistet, dass die Anwendung in Entwicklung, Test und Produktion identisch funktioniert.

-

Continuous Integration und Continuous Delivery (CI/CD): Die Kombination aus Docker und Kubernetes vereinfacht CI/CD-Pipelines. Docker-Images können in den CI/CD-Prozess integriert werden, um konsistentes Testen und Bereitstellung sicherzustellen. Kubernetes automatisiert den Bereitstellungsprozess, reduziert manuelle Eingriffe und beschleunigt die Time-to-Market für neue Funktionen.

-

Cloud-native Anwendungen: Docker und Kubernetes sind cloud-agnostisch, was es erleichtert, Anwendungen auf verschiedenen Cloud-Anbietern oder hybriden Umgebungen bereitzustellen. Diese Flexibilität ermöglicht es Organisationen, die geeignetste Infrastruktur auszuwählen und gleichzeitig Anbieterabhängigkeiten zu vermeiden.

Herausforderungen der Container-Orchestrierung

Sowohl Docker Swarm als auch Kubernetes haben unterschiedliche Ansätze zur Container-Orchestrierung, stehen jedoch vor ähnlichen Herausforderungen. Eine moderne Anwendung kann aus Dutzenden bis Hunderten von containerisierten Microservices bestehen, die reibungslos zusammenarbeiten müssen. Sie laufen auf mehreren Host-Maschinen, die als Knoten bezeichnet werden. Verbundene Knoten werden als Cluster bezeichnet. Halten Sie diesen Gedanken einen Moment lang fest und visualisieren Sie all diese Container und Knoten in Ihrem Kopf. Es wird sofort klar, dass eine Reihe von Mechanismen erforderlich sind, um ein derart verteiltes System zu koordinieren. Diese Mechanismen werden oft mit einem Dirigenten verglichen, der ein Orchester dirigiert, um aufwendige Symphonien und saftige Opern zu spielen. Glauben Sie mir, das Orchestrieren von Containern ähnelt mehr dem Hüten von Katzen als dem Arbeiten mit disziplinierten Musikern (einige behaupten, es sei wie das Hüten von Schrödingers Katzen). Hier sind einige der Aufgaben, denen Orchestrierungsplattformen gegenüberstehen müssen.

Container-Bereitstellung

Im einfachsten Sinne bedeutet dies, ein Container-Image aus dem Repository abzurufen und es auf einem Knoten bereitzustellen. Allerdings macht eine Orchestrierungsplattform viel mehr als das: Sie ermöglicht die automatische Neuerstellung fehlgeschlagener Container, rollende Bereitstellungen, um Ausfallzeiten für die Endbenutzer zu vermeiden, sowie das Verwalten des gesamten Container-Lebenszyklus.

Skalierung

Dies ist eine der wichtigsten Aufgaben, die eine Orchestrierungsplattform durchführt. Der “Scheduler” bestimmt die Platzierung neuer Container, damit die Rechenressourcen am effizientesten genutzt werden. Container können zur Anpassung an unterschiedlichen Endbenutzer-Trafficbedarf repliziert oder gelöscht werden.

Netzwerke

Die containerisierten Dienste müssen sich in sicherer Weise finden und miteinander kommunizieren können, was angesichts der dynamischen Natur der Container keine triviale Aufgabe ist. Darüber hinaus müssen einige Dienste, wie beispielsweise das Front-End, für Endbenutzer zugänglich gemacht werden, und ein Lastenausgleicher ist erforderlich, um den Verkehr auf mehrere Knoten zu verteilen.

Beobachtbarkeit

Eine Orchestrierungsplattform muss Daten über ihren internen Zustand und ihre Aktivitäten in Form von Protokollen, Ereignissen, Metriken oder Transaktionsverlaufsdaten bereitstellen. Dies ist unerlässlich, damit Betreiber den Zustand und das Verhalten der Container-Infrastruktur sowie der darin ausgeführten Anwendungen verstehen können.

Sicherheit

Sicherheit ist ein wachsender Bereich der Containerverwaltung. Eine Orchestrierungsplattform verfügt über verschiedene eingebaute Mechanismen, um Sicherheitslücken zu verhindern, wie sichere Bereitstellungspipelines für Container, verschlüsselten Netzwerkverkehr, Geheimspeicher und mehr. Diese Mechanismen allein reichen jedoch nicht aus und erfordern einen umfassenden DevSecOps-Ansatz.

Mit diesen Herausforderungen im Hinterkopf werfen wir einen genaueren Blick auf die Unterschiede zwischen Kubernetes und Docker Swarm.

Kubernetes vs Docker Swarm

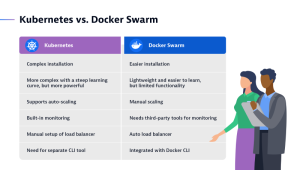

Sowohl Docker Swarm als auch Kubernetes sind Container-Orchestrierungsplattformen für den Einsatz in der Produktion, obwohl sie unterschiedliche Stärken haben. Docker Swarm, auch als Docker im Schwarmmodus bezeichnet, ist der einfachste Orchestrator, der bereitgestellt und verwaltet werden kann. Es kann eine gute Wahl für eine Organisation sein, die gerade erst damit beginnt, Container in der Produktion einzusetzen. Swarm deckt solide 80% aller Anwendungsfälle mit 20% der Komplexität von Kubernetes ab.

Ein Schwarm besteht aus einem oder mehreren Knoten, die physische oder virtuelle Maschinen sind und Docker Engine ausführen.

Swarm integriert sich nahtlos in den Rest der Docker-Tool-Suite, wie Docker Compose und Docker CLI, und bietet eine vertraute Benutzererfahrung mit einer flachen Lernkurve. Wie von einem Docker-Tool zu erwarten, kann Swarm überall dort ausgeführt werden, wo auch Docker läuft, und es gilt als standardmäßig sicher und einfacher zu beheben als Kubernetes.

Kubernetes, oder kurz K8s, ist die bevorzugte Orchestrierungsplattform für 88% der Organisationen. Ursprünglich von Google entwickelt, ist es jetzt in vielen Distributionen verfügbar und wird von allen öffentlichen Cloud-Anbietern weitgehend unterstützt. Amazon Elastic Kubernetes Service, Microsoft Azure Kubernetes Service und Google Kubernetes Platform bieten jeweils ihren eigenen verwalteten Kubernetes-Dienst an. Weitere beliebte Distributionen sind Red Hat OpenShift, Rancher/SUSE, VMWare Tanzu und IBM Cloud Kubernetes Services. Diese breite Unterstützung vermeidet eine Abhängigkeit von Anbieter und ermöglicht es DevOps-Teams, sich auf ihr eigenes Produkt zu konzentrieren, anstatt mit Infrastruktur-Idiosynkrasien kämpfen zu müssen.

Die wahre Stärke von Kubernetes liegt in seiner nahezu grenzenlosen Skalierbarkeit, Konfigurierbarkeit und seinem reichen Technologie-Ökosystem, das viele Open-Source-Frameworks für Überwachung, Management und Sicherheit bietet.

Docker und Kubernetes: Gemeinsam stärker

Einfach ausgedrückt sind die Docker-Suite und Kubernetes Technologien mit unterschiedlichem Anwendungsbereich. Sie können Docker ohne Kubernetes und umgekehrt verwenden, aber sie arbeiten gut zusammen.

Vom Standpunkt des Softwareentwicklungszyklus aus betrachtet ist Docker zu Hause in der Entwicklung. Dies umfasst Konfiguration, Erstellung und Verteilung von Containern mit Hilfe von CI/CD-Pipelines und DockerHub als Bild-Registry. Kubernetes hingegen glänzt im Bereich des Betriebs, indem es Ihnen ermöglicht, Ihre vorhandenen Docker-Container zu nutzen und gleichzeitig die Komplexität von Bereitstellung, Netzwerk, Skalierung und Überwachung zu bewältigen.

Obwohl Docker Swarm in diesem Bereich eine Alternative ist, ist Kubernetes die beste Wahl, wenn es darum geht, große verteilte Anwendungen mit Hunderten von verbundenen Microservices, einschließlich Datenbanken, Geheimnissen und externen Abhängigkeiten, zu orchestrieren.

Wie profitieren Kubernetes und Docker Swarm von erweiterter Beobachtbarkeit?

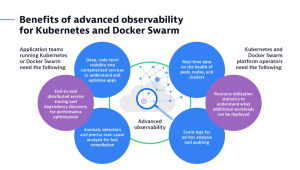

Ob Sie nun Kubernetes oder Docker Swarm oder beides verwenden, die Verwaltung von Clustern in großem Maßstab bringt einzigartige Herausforderungen mit sich, insbesondere in Bezug auf die Beobachtbarkeit. Sowohl Anwendungsteams als auch Kubernetes/Swarm-Plattformbetreiber sind auf detaillierte Überwachungsdaten angewiesen. Hier sind einige Beispiele.

Kubernetes bietet einige sehr grundlegende Überwachungsfunktionen, wie Ereignisprotokolle und CPU-Auslastung zum Beispiel. Es gibt jedoch eine wachsende Anzahl von Open-Standard- und Open-Source-Technologien, die Kubernetes’ integrierte Funktionen ergänzen. Einige häufig verwendete Beobachtungswerkzeuge sind zum Beispiel Promtail, Fluentbit und Fluentd für Protokolle; Prometheus für Metriken; und OpenTelemetry für Spuren, um nur einige zu nennen.

Dynatrace integriert sich in all diese Tools und mehr und fügt eigene hochwertige Daten hinzu, um ein einziges Echtzeit-Entitätsmodell zu erstellen. Diese einzigartige Fähigkeit ermöglicht es Dynatrace, fortschrittliche Analysen, KI-gestützte Ursachenanalyse und intelligente Automatisierung bereitzustellen und Anwendungsteams und Plattformbetreibern eine einheitliche Sicht auf den gesamten Technologiestack zu bieten.

Die Kombination aus Kubernetes und Docker bietet eine leistungsstarke Plattform für die Bereitstellung, Verwaltung und Skalierung von containerisierten Anwendungen. Obwohl sie unterschiedliche Stärken haben, arbeiten sie gut zusammen, um den Anforderungen moderner Anwendungen gerecht zu werden. Also, warum wählen Sie nicht das Beste aus beiden Welten und erforschen Sie, was Kubernetes und Docker für Ihre Projekte tun können?